Certámenes fotográficos: un (breve) recuento

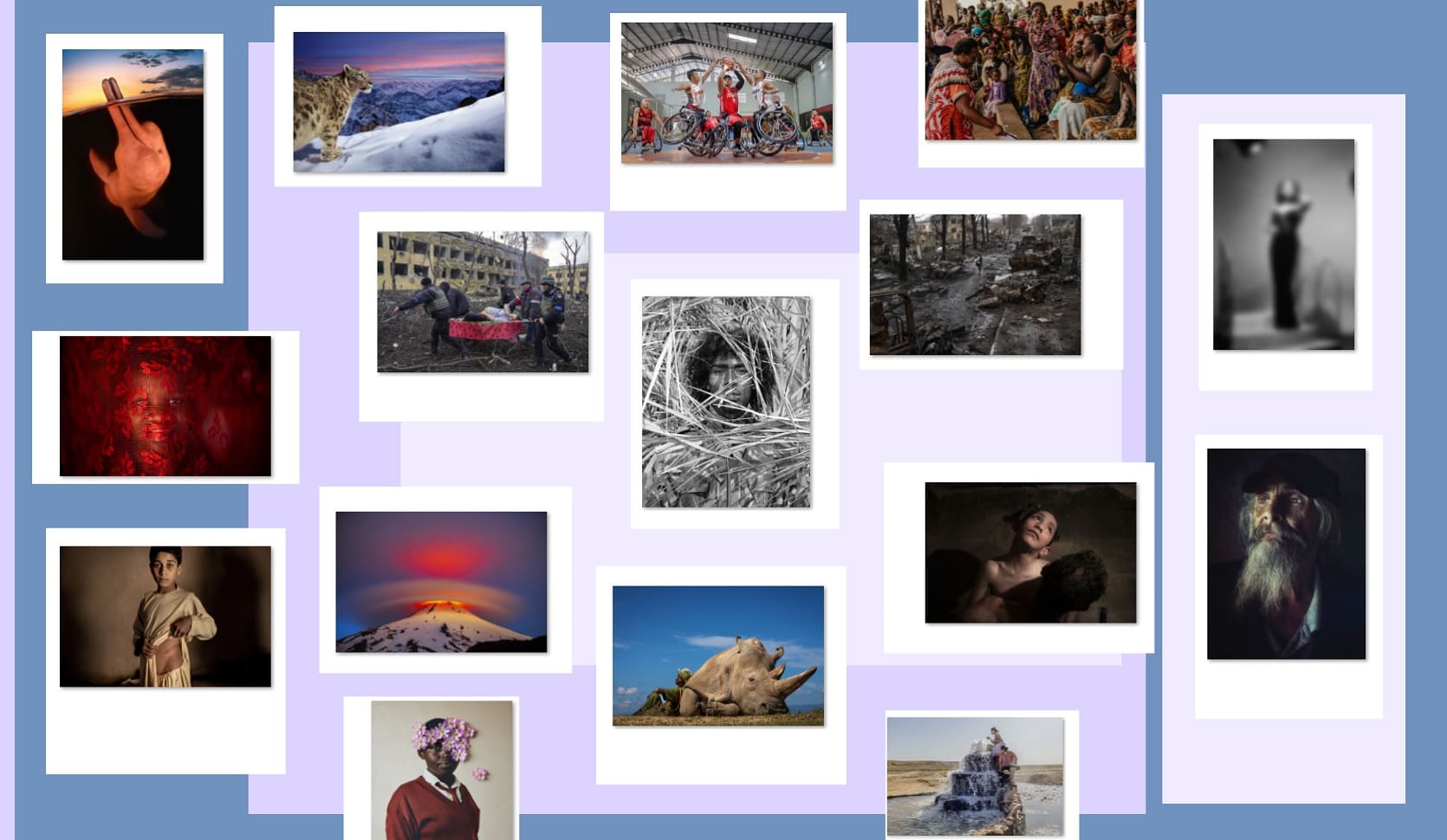

Tomando como punto de partida los resultados (y ganadores) de varios de los certámenes más importantes de fotografía en lo que va del año, hemos preparado —ahora que han transcurrido seis meses completos de 2023— una nueva selección de imágenes para las paredes virtuales de nuestra ‘Galería Emergente’. Como suele ocurrir con la mayoría de los concursos de foto, muchas de las imágenes ahora premiadas y destacadas fueron protagonistas en su momento —en este caso, 2022—, dejando un registro visual de este mundo convulso que no siempre muestra su mejor rostro. Crisis climática, pugnas sociales, conflictos bélicos, desplazamientos masivos son los temas que sobresalen en los concursos (y en las fotografías ganadoras), pero, de vez en vez, también se cuela la vida cotidiana y mundana… y animal.

Ganador principal del premio Travel Photographer of the Year, uno de los certámenes de fotografía de viajes más importantes. En la imagen vemos a Najin, uno de los dos últimos rinocerontes blancos que quedan en el mundo, descansando bajo el sol de la tarde en la compañía de su amigo y cuidador Zachary Mutai.

Con el título de World of the snow leopard (El mundo del leopardo de las nieves), esta foto fue elegida como la ganadora del Wildlife Photographer of the Year. Fonseca utilizó una cámara trampa para captar la imagen de este gran felino al atardecer, con las montañas de Ladakh, en el norte de la India, como telón de fondo.

Ganador principal del Underwater Photographer of the Year 2023, el concurso de fotografía subacuática más prestigioso del mundo. En la imagen, titulada Boto encantado, se puede observar a un delfín rosado atravesando la superficie del río Amazonas.

Ganador principal del ya reconocido concurso Mobile Photography Awards (fotos tomadas con cualquier tipo de teléfono celular o con tablet). La imagen, titulada Old Mate (Viejo camarada), pertenece al portafolio con el cual ha ganado Homann, que incluye diferentes géneros como foto de calle, paisaje, retrato y arquitectura.

En marzo se dio a conocer al ganador del prestigioso Hasselblad Award 2023, que se otorga por el conjunto de una obra. Considerado por algunos como el Nobel de la Fotografía, la artista estadounidense fue la ganadora por su profunda obra “personal y política”.

Ganador principal del SkyPixel 8th Annual Photo & Video Contest, el cual premia las mejores imágenes aéreas (tomadas con drones). Titulada Floral Dress, la imagen captura a una mujer cosechando nenúfares —flores que crecen en lagos, lagunas, arroyos o pantanos—, las cuales, al crecer en el agua y ser recolectadas, suelen formar imágenes espectaculares, en este caso un vestido floral.

Ganador principal del All About Photo Awards – The Mind’s Eye 2023, certamen que en su octavo año ha logrado posicionarse entre los más destacados de la temporada. Titulada The Winning Shoot, la imagen casi simétrica captura al equipo nacional de baloncesto en silla de ruedas de Indonesia en medio de un partido intenso, justo cuando el tiro decisivo está a punto de lanzarse.

Premio “Photographer of the Year” en el Sony World Photography Awards, uno de los certámenes más prestigiosos de la foto. El proyecto ganador, intitulado “Our War”, es un homenaje al amigo de Martins, el fotoperiodista Anton Hammerl, quien fue asesinado a tiros durante la Guerra Civil de Libia en 2011.

Los Sony World Photography premian imágenes de estilos muy diferentes, con contenido muy diverso. Para su proyecto The Right To Play (El derecho a jugar), ganador en la categoría “Creativo”, Lee-Ann Olwage trabajó con niñas de Kakenya’s Dream en Enoosaen, Kenia, una organización que han evitado la mutilación genital femenina y el matrimonio infantil en este país africano.

Ganador en la categoría “Proyectos documentales”, en los Sony World Photography, The Women’s Peace Movement in Congo (El movimiento de mujeres por la paz en el Congo) documenta el lento trabajo de la paz —y la enorme dificultad de ser mujer libre en dicho país—, tras 20 años de un conflicto que mató a más de cinco millones de personas.

La ganadora como Fotografía del Año, del prestigioso certamen World Press Photo, retrata a Iryna Kalinina, de 32 años, una mujer embarazada que fue rescatada de un hospital materno infantil en Mariupol, Ucrania, tras ser bombardeado por las fuerzas invasoras rusas. A punto de dar a luz en el momento del ataque, el bebé nació muerto y ella falleció media hora después. Evgeniy Maloletka labora para la agencia Associated Press.

En la categoría Reportaje Gráfico del Año, de World Press Photo 2023, el reconocimiento fue para el danés Mads Nissen por “El precio de la paz en Afganistán” (“The Price of Peace in Afghanistan”). En la imagen está Khalil Ahmad; sus padres ya no podían permitirse comprar alimentos para sus once hijos, por lo que, en un intento desesperado por salvar a la familia, decidieron vender el riñón izquierdo de Khalil. Mads Nissen fotografió esta historia para Politiken.

En la categoría Proyecto a Largo Plazo (en su sección Global), del premio World Press Photo 2023, la ganadora fue Anush Babajanyan, cuyo trabajo ilustra el impacto de la gestión del agua en Asia Central tras la desintegración de la Unión Soviética, y por la crisis del clima. En la imagen, una fuente termal surge en el antiguo lecho del mar de Aral, cerca del pueblo de Akespe (Kazajistán). A lo largo de los años, el mar de Aral ha perdido el 90 por ciento de sus aguas.

Mención especial merece la categoría Proyecto a Largo Plazo (en su sección para Norte y Centroamérica), de World Press Photo 2023, pues el ganador fue el mexicano Cristopher Rogel con la serie “Beautiful poison” (“Hermoso veneno”), en donde muestra de manera íntima la vida de las familias de Villa Guerrero, quienes sufren graves consecuencias en su salud por el uso constante de pesticidas tóxicos que emplean en el cultivo de las flores que venden.

Fotógrafo del año, de los London Photography Awards, fue para Francisco Negroni, por esta toma del Volcán Villarrica. El fotógrafo chileno le dijo al medio infobae que no trabaja con filtros. “Hago todas mis fotografías en formato RAW, que son como los negativos de la foto. (…) El archivo RAW es incorruptible, sirve para mostrar, en caso que alguien tenga dudas de tu trabajo, que la foto no está trucada”.

Premios Pulitzer. La categoría de fotografía editorial, ‘Breaking News Photography’, fue para el equipo de fotógrafos de la agencia estadounidense Associated Press por la cobertura realizada en las primeras semanas de la invasión rusa en Ucrania. En la imagen, una mujer camina entre tanques rusos destruidos en Bucha, en las afueras de Kiev, el 3 de abril de 2022.

Premios Pulitzer. La categoría ‘Feature Photography’, que premia el mejor trabajo de fotoperiodismo del año, fue para Christina House de Los Angeles Times. Su serie es una mirada íntima a la vida de una mujer embarazada de 22 años que vive en la calle, en una tienda de campaña; imágenes que muestran su vulnerabilidad emocional.

El concurso de fotografía documental Pictures of the Year International (POY) fue creado, en 1944, por la Escuela de periodismo de la Universidad de Missouri-Columbia, cuyo programa de fotoperiodismo es el más antiguo del mundo y uno de los más respetados. En 2011, el concurso creció hacia Iberoamérica y fue creado el POY Latam; una década después, es ya uno de los más importantes en la región. Federico Ríos fue seleccionado como el Fotógrafo Iberoamericano del Año en el POY Latam 2023.

Una mención especial merece el artista alemán Boris Eldagsen, quien puso de cabeza al mundo de la foto al presentarse al famoso concurso Sony World Photography Awards 2023 con su serie “Pseudomnesia”, y ganar con The Electrician, una imagen que había sido generada con la ayuda de inteligencia artificial, en la categoría Creativa. Fue él mismo quien se autodenunció y rechazó el premio tras saberse ganador. Según sus declaraciones, su objetivo era “acelerar el proceso de los organizadores del Premio para tomar conciencia de esta diferencia y crear concursos separados para imágenes generadas por IA”. Para el artista, “trabajar con generadores de imágenes de IA es una cocreación. (…) No se trata de presionar un botón, y listo. Se trata de explorar la complejidad de este proceso”.

¡Excelente recuento de certámenes! Es muy valioso ver la calidad del talento que se está premiando a nivel internacional. Me detuve a apreciar el retrato de Glenn Homann.

Técnicamente, el uso de la iluminación Rembrandt para acentuar el rostro y la barba crea un contraste dramático que, combinado con la profundidad de campo, aísla al sujeto y enfoca toda la atención en la intensidad de su mirada. Es una demostración de que la calidad de una foto reside en la visión del artista y no en la cámara.

Felicitaciones a los autores por este artículo y por dar voz a estos talentos.